L’Ultra HD, la 4K, le HDR : tout cela signifie peut-être un peu la même chose pour vous. Vous n’avez pas complètement tort, ces différents sigles sont liés entre eux. Ils tournent tous autour de l’ultra haute définition qui remplace petit à petit la Full HD. Mais ce n’est pas pour autant qu’ils sont interchangeables. Et puis dans ce même domaine, d’autres termes que vous voyez de plus en plus ont leur importance comme le Dolby Vision, les nits ou le 4:4:4. Ce dossier va vous permettre de tout comprendre et de tout bien différencier. Vous serez alors incollable sur le sujet.

Ultra HD et 4K : deux résolutions différentes

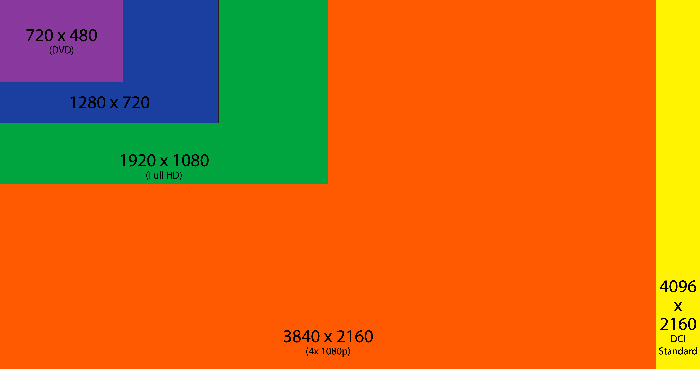

On utilise souvent l’un pour dire l’autre et vice-versa. Et pourtant, ils ne sont pas identiques ! Le format Ultra HD correspond aux sources et afficheurs grand public. Ce sont les téléviseurs, les lecteurs de Blu-ray UHD ainsi que la résolution des disques UHD BD. Cette résolution est de 3840×2160 pixels. L’image 4K est légèrement plus large : 4096×2160 pixels. Elle correspond aux applications professionnelles. C’est aussi le format utilisé dans les salles de cinéma numériques.

Le terme court « 4K » est bien pratique. Cependant, il est préférable d’utiliser le bon terme dans le bon environnement pour être sûr de bien se faire comprendre. En effet, tous les équipements Ultra HD ne sont pas forcément compatibles 4K.

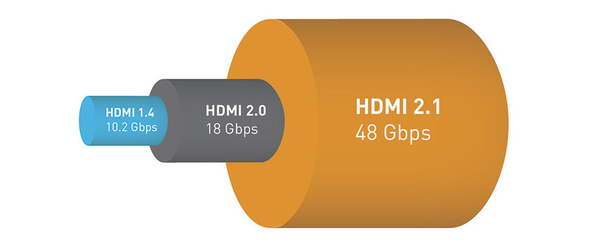

L’un comme l’autre sont capables de transiter à travers un câble HDMI, DisplayPort, SDI ou USB-C. La nouvelle norme HDMI 2.1 qui arrive en 2018 pourrait changer la donne.

Un débit important

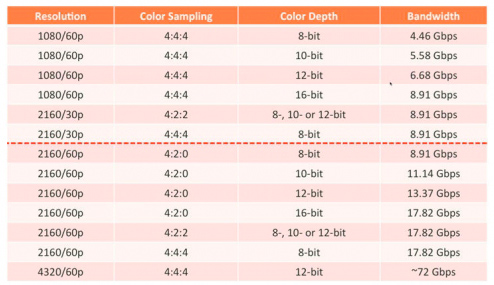

En effet, plus on monte en résolution et plus on ajoute d’informations à faire passer sur un même câble. Aujourd’hui, en HDMI 2.0, le débit maximal peut atteindre 18 Gbps. C’est déjà important et cela a des contraintes sur la qualité des câbles utilisés. 18 Gbps non compressés passent sur un câble HDMI de faible longueur, 5-7 mètres tout au plus. Au-delà, il faut soit compresser le signal, soit passer sur une fibre optique.

Source : AudioVideoHD

Source : AudioVideoHD

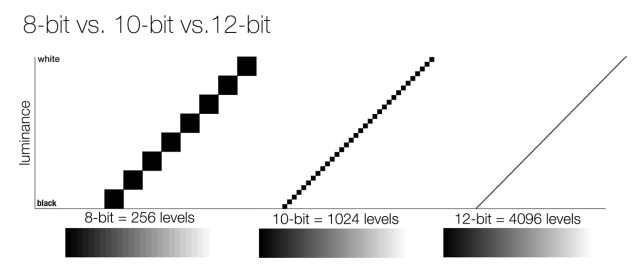

La profondeur de couleur est un autre élément qui pèse lourd dans la balance. En 8, 10 ou 12 bits, l’espace nécessaire pour stocker ces informations de luminance n’est pas du tout le même. En contrepartie, on obtient une palette plus ou moins importante. Le schéma ci-dessous montre bien la montée en précision assez évidente.

Source : Reviewed.com / TJ Donegan

Source : Reviewed.com / TJ Donegan

La guerre du HDR

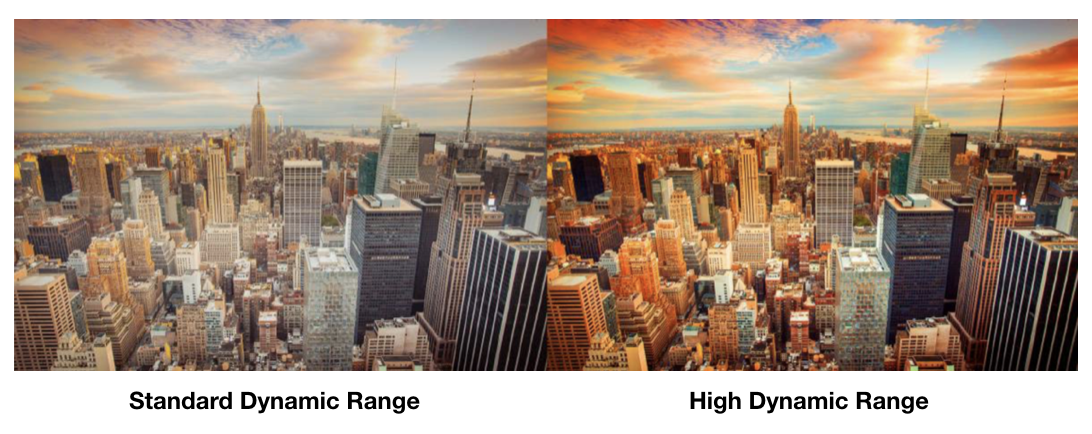

Parce que le HDMI 2.0 n’a pas apporté qu’un surplus de résolution, c’est grâce à lui que nous avons droit désormais au HDR (High Dynamic Range). L’objectif du HDR est de maximiser la restitution de la luminosité, ce qui améliore de fait le contraste et les couleurs. Les étoiles sont plus brillantes, les couchers de soleil plus éclatants. On se rapproche de la réalité.

Source : Lightware

Source : Lightware

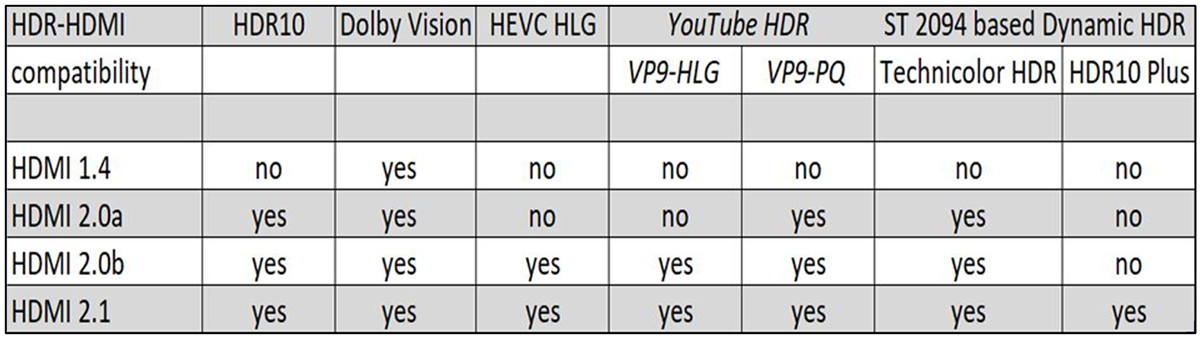

Cela aurait pu être assez simple si plusieurs solutions HDR n’avaient pas vu le jour simultanément. On a droit aujourd’hui à trois formats : HDR10, HLG et Dolby Vision. Le HDR10 est le plus répandu, car sans licence d’utilisation. Le HLG, développé par la BBC et la NHK, est rétro-compatible, dans une certaine mesure, avec des écrans non HDR. Enfin, le Dolby Vision est le plus avancé, mais comme il est sous licence, il est encore peu utilisé. En HDMI 2.1, il y en aura au moins un de plus, le HDR10+, proche du Dolby Vision, mais sans licence.

Source : AVS Forum

Source : AVS Forum

Le Dolby Vision et le HDR10+ ont la particularité de transmettre des informations en parallèle de l’image afin de dire précisément à l’afficheur comment il doit se comporter, scène par scène. L’efficacité est alors à son maximum.

Les nits, nouvelle valeur de référence

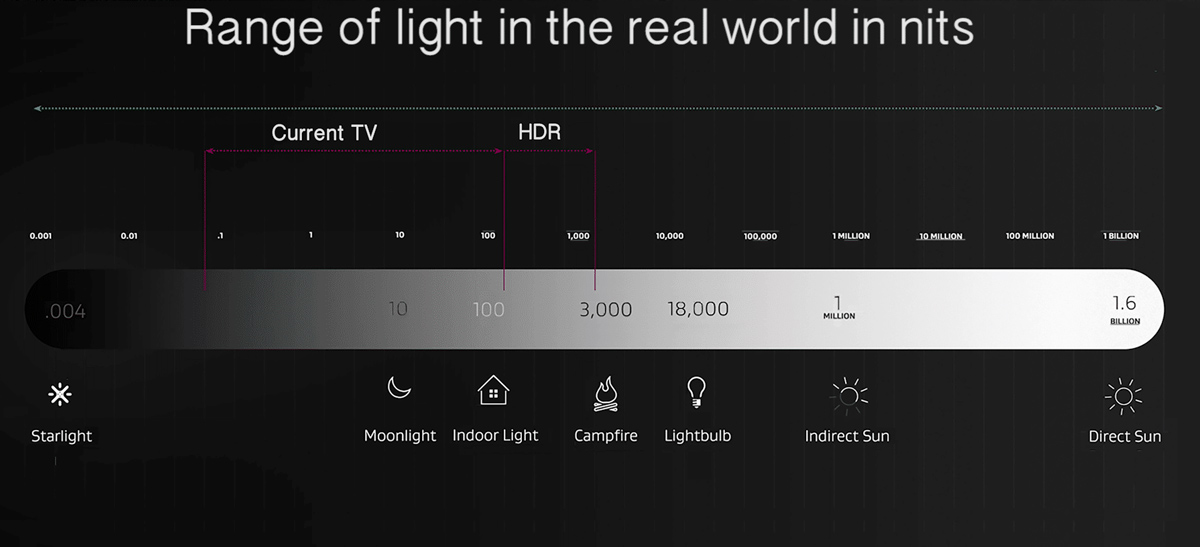

Un nit est une unité de mesure qui correspond à un candela/m2, il est de plus en plus utilisé dans le monde de l’audiovisuel. C’est une mesure de luminance correspondante à la sensation visuelle de luminosité d’une surface, telle qu’elle peut être perçue par l’oeil. Les écrans plats SDR (non HDR) atteignent 100 nits. Les écrans compatibles HDR doivent atteindre un minimum de 540 nits. Les meilleurs écrans actuels montent à 2.000 nits. La norme SMPTE ST 2084 voudrait même que l’on atteigne à terme 10.000 nits.

Plus ce chiffre est élevé, et plus les fortes luminosités seront fidèlement reproduites. Au point de devenir éblouissantes, comme dans la vraie vie !

Source : Five Things Series

Source : Five Things Series

L’organisme VESA a même décidé de proposer une certification des écrans HDR en fonction de leur capacités en nits (400, 600 ou 1000). On pourrait alors retrouver un logo supplémentaire sur nos écrans, qui a au moins le mérite de vouloir clarifier cette donnée assez obscure pour le grand public.

Source : VESA

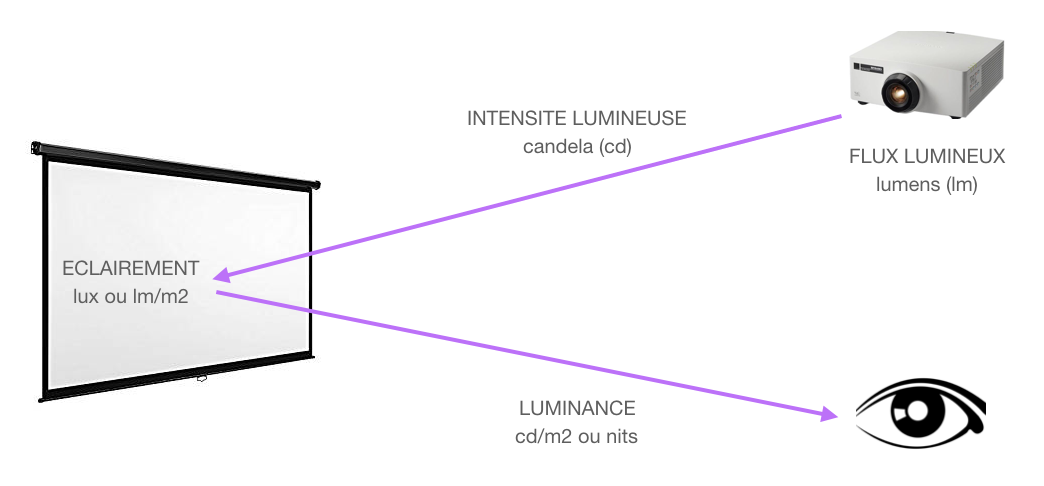

Dans le monde de la vidéoprojection, l’image étant réfléchie sur un écran, atteindre de tels pics de luminosité devient vite très compliqué. Plus on voudra monter en luminance et plus la lampe ou le laser du vidéoprojecteur devra être puissant. A titre d’exemple, pour un écran de 3 mètres de base et pour obtenir 100 nits, donc sans HDR, il faut déjà un vidéoprojecteur d’une puissance de 1570 lumens (voir la formule ici).

On acceptera plus facilement sur une image projetée de ne pas forcément avoir cette sensation de pics de luminosité importants, à l’inverse d’un écran plat OLED par exemple. Dans des applications professionnelles où la vidéoprojection doit savoir faire du HDR, on pourra mettre le paquet sur la puissance pour y remédier.

Echantillonnage et sous-échantillonnage 4:4:4, 4:2:2, 4:2:0

En dehors de la résolution et des pics de luminosité du HDR, il y a d’autres données à prendre en compte comme le nombre d’images par seconde ainsi que l’échantillonnage. On atteint aujourd’hui un maximum de 60 images par seconde, ce qui a pour intérêt principal de fluidifier le mouvement, sans faire appel à des artifices tels que le « 100 Hz » (et plus). Avec la norme HDMI 2.1, on pourra déjà monter à 120 images par seconde. Il faudra simplement que les films soient tournés à cette fréquence pour en tirer les bénéfices.

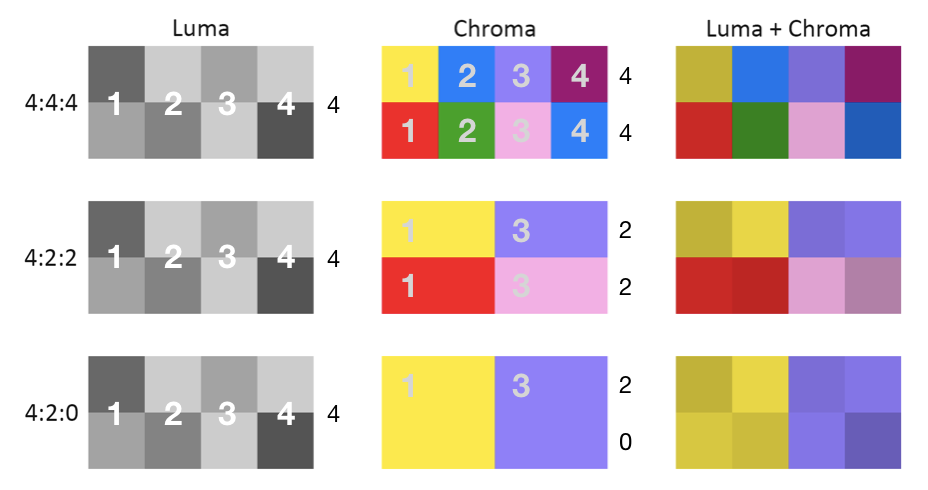

Le sous-échantillonnage concerne lui un travail de compression sur les couleurs. La base, c’est le 4:4:4, avec huit informations de luminance (l’intensité lumineuse qui s’étend du noir au blanc) et deux fois quatre informations de chrominance (les couleurs). Le schéma ci-dessous est bien plus pertinent qu’un long discours.

Source : Rtings

Source : Rtings

Comme on le voit sur la première ligne, en 4:4:4, on a huit informations de luminance combinées à huit informations de chrominance. Il n’y a aucune compression, aucune perte.

Dans les deux cas en-dessous, on a supprimé la moitié (4:2:2), plus les 3/4 des informations de chrominance (4:2:0). Si cela a été mis en place ainsi, c’est que cette compression est quasiment invisible à l’oeil. Et finalement, les disques Blu-ray Ultra HD sont tous en 4:2:0 ! On économise de la place sur le disque et de la bande passante.

Dans les applications professionnelles, on peut bien entendu souhaiter rester en 4:4:4. Il faudra là bien faire attention aux équipements choisis : ils devront être capables de reproduire correctement la totalité des informations d’un signal 4:4:4.

En résumé

En résumé, un signal vidéo ultra haute définition comprend les caractéristiques suivantes :

- résolution – exemple : Ultra HD ou 2160p

- nombre d’images par seconde – exemple : 25 i/s

- échantillonnage – exemple : 4:2:0

- profondeur de couleur – exemple : 10 bits

- HDR – exemple : HDR10

Bientôt la 8K ?

La 4K n’est pas encore généralisée que l’on nous parle déjà de 8K. L’innovation ne s’arrête jamais ! Ca tombe bien, la norme HDMI 2.1 est déjà prête pour laisser passer des programmes avec une résolution aussi importante, contenant plus d’images par seconde, plus de données entre la source et l’écran, etc.

Mais nous arriverons à une nouvelle limite, celle du câble en cuivre, qu’il soit HDMI ou Ethernet. Ces câbles auront de plus en plus de mal à faire transiter des débits pouvant atteindre 48 Gbps. Nous verrons alors peut-être les câbles optiques se généraliser pour le grand public !

Laisser un commentaire